AI

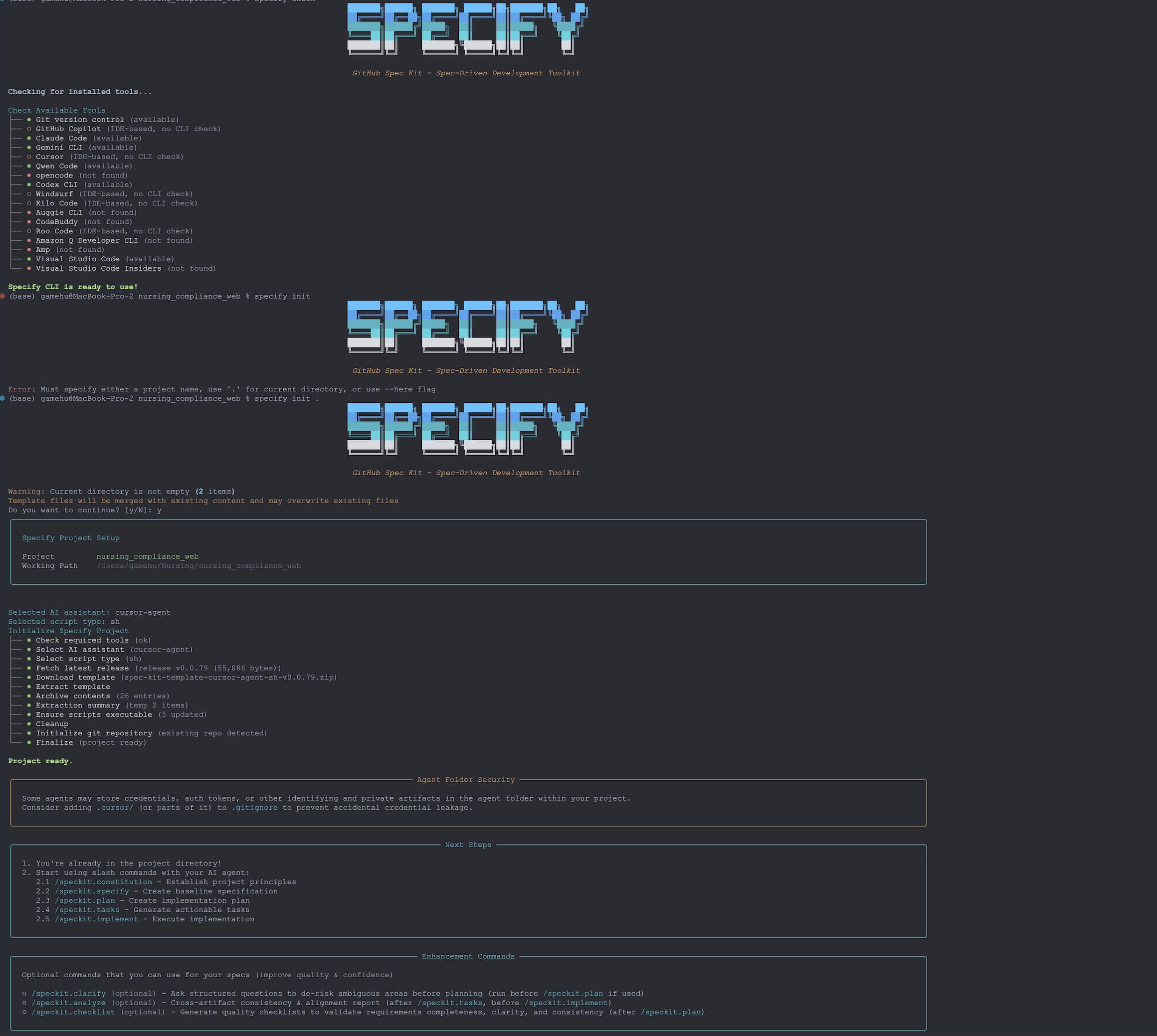

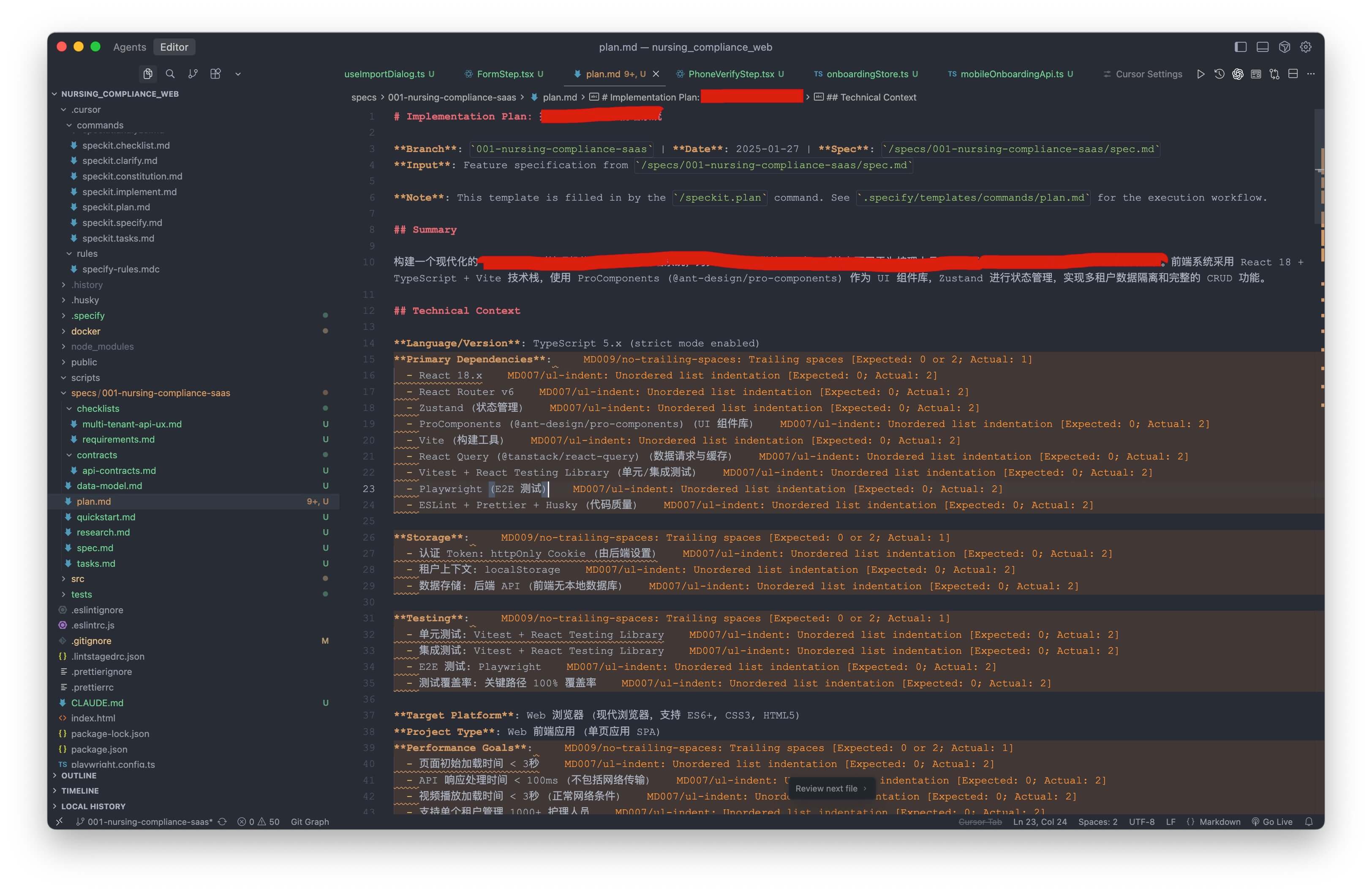

Spec-kit

掌握大型语言模型:50道面试题终极指南

本文基于一篇优秀的Medium文章,解析并提炼了50道经典LLM面试题。我对内容进行了润色和优化,使其更简洁、实用,同时保留了核心知识点。此次版本特别结合了相关图示,帮助你更直观地理解复杂概念。无论你是求职者、面试官,还是AI爱好者,这份指南都能帮你快速掌握LLM的核心概念、机制和应用。

这些问题涵盖了从基础原理到高级技巧的方方面面,每个问题后附带简明解释,帮助你获得“顿悟”时刻。让我们一起来探索吧!

1. 什么是分词(Tokenization),为什么它对LLM至关重要?

分词是将文本分解成更小的单位(如单词、子词或字符)的过程。例如,“artificial”可能被拆分成“art”、“ific”和“ial”。这对LLM至关重要,因为模型处理的是数字而非原始文本。分词能处理多种语言、稀有词汇,并优化词汇表大小,提高计算效率和模型性能。

注意力机制允许LLM在生成或解释文本时,权衡序列中不同token的重要性。它通过查询(query)、键(key)和值(value)向量计算相似度分数(如点积)。例如,在“The cat chased the mouse”中,它能将“mouse”与“chased”关联起来,提升上下文理解,使Transformer在NLP任务中表现出色。

3. LLM中的上下文窗口是什么,为什么重要?

上下文窗口是指LLM一次能处理的token数量上限(如32,000个token),它定义了模型的“记忆”范围。更大的窗口能提升如摘要生成的任务连贯性,但会增加计算成本。在实际部署中,平衡窗口大小与效率是关键。

4. LoRA和QLoRA在LLM微调中的区别是什么?

LoRA(Low-Rank Adaptation)通过添加低秩矩阵来高效微调模型,减少内存开销。QLoRA在此基础上引入量化(如4-bit精度),进一步降低内存需求。例如,QLoRA能让70B参数模型在单GPU上微调,适合资源有限的环境。

5. 束搜索(Beam Search)如何比贪婪解码(Greedy Decoding)更好地生成文本?

束搜索在生成文本时保留前k个(例如k=5)最佳序列,探索更多路径,而贪婪解码只选最高概率词。这能产生更连贯的输出,尤其在机器翻译或对话生成中,平衡概率与多样性。

6. 温度(Temperature)在控制LLM输出中扮演什么角色?

温度是一个超参数,用于调整文本生成的随机性。低温度(如0.3)偏好高概率token,输出更可预测;高温度(如1.5)增加多样性。通过设置如0.8,能在创意任务如讲故事中平衡创造力和连贯性。

7. 什么是掩码语言建模(Masked Language Modeling),它如何辅助预训练?

掩码语言建模(MLM)是将序列中随机token隐藏,并训练模型基于上下文预测它们。如BERT模型中使用,这促进双向语言理解,捕捉语义关系,为情感分析或问答等任务打下基础。

8. 序列到序列(Seq2Seq)模型是什么,在哪里应用?

Seq2Seq模型将输入序列转换为输出序列(长度可不同),由编码器处理输入、解码器生成输出。应用包括机器翻译(如英文到西班牙文)、文本摘要和聊天机器人,处理变长输入输出。

9. 自回归模型和掩码模型在LLM训练中的区别是什么?

自回归模型(如GPT)基于先前token顺序预测,擅长生成任务如文本补全。掩码模型(如BERT)使用双向上下文预测掩码token,适合分类等理解任务。训练目标决定了它们在生成 vs. 理解上的优势。

10. 什么是嵌入(Embeddings),在LLM中如何初始化?

嵌入是将token表示为连续空间中的稠密向量,捕捉语义和句法属性。通常随机初始化或用预训练如GloVe,然后在训练中微调。例如,“dog”的嵌入可能在宠物相关任务中演化,提升模型准确性。

11. 什么是下一句预测(Next Sentence Prediction),它如何提升LLM?

下一句预测(NSP)训练模型判断两句是否连续(50%正样本,50%负样本)。如BERT中使用,这改善如对话系统或文档摘要的任务连贯性,通过理解句子关系。

12. Top-k和Top-p采样在文本生成中的区别是什么?

Top-k采样选择前k个最高概率token(如k=20)随机采样,确保控制多样性。Top-p(核采样)选择累积概率超过阈值p(如0.95)的token,更灵活。在创意写作中,Top-p能产生多样且连贯的输出。

13. 为什么提示工程(Prompt Engineering)对LLM性能至关重要?

提示工程是设计输入以引发理想响应的艺术。例如,“用100字总结这篇文章”比模糊指令更有效。在零样本或少样本设置中,它让LLM无需大量微调就能处理翻译或分类任务。

14. LLM如何在微调中避免灾难性遗忘(Catastrophic Forgetting)?

灾难性遗忘是微调抹除先前知识的现象。缓解方法包括:重放(混合旧新数据)、弹性权重整合(保护关键权重)、模块化架构(添加任务特定模块)。这些确保LLM在多任务中保持多功能性。

15. 什么是模型蒸馏(Model Distillation),它如何益处LLM?

模型蒸馏训练“小学生”模型模仿“大老师”模型的输出,使用软概率而非硬标签。这减少内存和计算需求,让模型能在智能手机上部署,同时保留近似性能,适合实时应用。

16. LLM如何处理词汇表外(OOV)词?

LLM使用子词分词如字节对编码(BPE),将OOV词拆分成已知子词。例如,“cryptocurrency”拆成“crypto”和“currency”。这确保处理稀有或新词,增强语言理解和生成鲁棒性。

Transformer通过并行处理(自注意力同时处理token)、捕捉长距离依赖、位置编码(保留顺序)来改进。相比RNN的顺序处理,这些提升了可扩展性和如翻译任务的性能。

18. 什么是过拟合(Overfitting),在LLM中如何缓解?

过拟合是模型记忆训练数据但无法泛化。缓解包括:正则化(L1/L2惩罚)、Dropout(随机禁用神经元)、早停(验证性能停滞时停止)。这些确保对未见数据的鲁棒泛化。

19. NLP中的生成模型和判别模型有什么区别?

生成模型(如GPT)建模联合概率,创建新数据如文本。判别模型(如BERT分类)建模条件概率,区分类别如情感分析。生成模型擅长创建,判别模型聚焦准确分类。

20. GPT-4与GPT-3在功能和应用上的区别是什么?

GPT-4超越GPT-3的多模态输入(文本+图像)、更大上下文(25,000 vs. 4,096 token)、更高准确性(减少事实错误)。这扩展了其在视觉问答和复杂对话的应用。

21. 什么是位置编码(Positional Encodings),为什么使用?

位置编码为Transformer输入添加序列顺序信息,因为自注意力无固有顺序。用正弦函数或学习向量,确保如“king”和“crown”基于位置正确解释,关键于翻译任务。

22. 什么是多头注意力(Multi-Head Attention),它如何提升LLM?

多头注意力将查询、键、值拆分成多个子空间,同时关注输入的不同方面。例如,一头关注句法,另一头关注语义。这提升模型捕捉复杂模式的能力。

23. Softmax函数在注意力机制中如何应用?

Softmax将注意力分数规范化成概率分布:在注意力中,将原始相似分数(查询-键点积)转为权重,强调相关token,确保模型聚焦上下文重要部分。

24. 点积在自注意力中如何贡献?

在自注意力中,查询(Q)和键(K)向量的点积计算相似分数:高分表示相关token。尽管高效,但其二次复杂度(O(n²))促使研究稀疏注意力。

25. 为什么在语言建模中使用交叉熵损失(Cross-Entropy Loss)?

交叉熵测量预测与真实token概率的差异:它惩罚错误预测,鼓励准确token选择。在语言建模中,确保模型为正确下一token分配高概率,优化性能。

26. LLM中嵌入的梯度如何计算?

嵌入梯度通过链式法则在反向传播中计算:这些梯度调整嵌入向量以最小化损失,精炼语义表示,提升任务性能。

Jacobian矩阵捕捉输出对输入的部分导数。在Transformer中,它帮助计算多维输出的梯度,确保权重和嵌入的准确更新,优化复杂模型。

28. 特征值和特征向量如何与降维相关?

特征向量定义数据主方向,特征值表示方差。在PCA中,选择高特征值的向量减少维度,同时保留大部分方差,便于LLM输入处理。

29. 什么是KL散度(KL Divergence),在LLM中如何使用?

KL散度量化两个概率分布的差异:在LLM中,它评估模型预测与真实分布的接近度,指导微调改善输出质量和数据对齐。

30. ReLU函数的导数是什么,为什么重要?

ReLU函数f(x) = max(0, x)的导数为:1 (x > 0),0 (x ≤ 0)。其稀疏性和非线性防止梯度消失,使ReLU在LLM中高效且广泛使用。

31. 链式法则如何应用于LLM中的梯度下降?

链式法则计算复合函数导数:在梯度下降中,它启用反向传播逐层计算梯度,高效更新参数,最小化深度LLM架构的损失。

注意力分数计算为:缩放点积测量token相关性,Softmax规范化分数,聚焦关键token,提升如摘要的上下文生成。

33. Gemini如何优化多模态LLM训练?

Gemini通过统一架构(结合文本和图像)、高级注意力(提升跨模态学习稳定性)、数据效率(自监督减少标签需求)来优化。更稳定、可扩展于如GPT-4。

34. 基础模型有哪些类型?

基础模型包括:语言模型(BERT、GPT-4用于文本)、视觉模型(ResNet用于图像分类)、生成模型(DALL-E用于内容创建)、多模态模型(CLIP用于文本-图像)。它们利用广泛预训练适用于多样应用。

35. PEFT如何缓解灾难性遗忘?

参数高效微调(PEFT)仅更新小部分参数,冻结其余以保留预训练知识。如LoRA,确保LLM适应新任务而不丢失核心能力,维持跨域性能。

36. 检索增强生成(RAG)的步骤是什么?

RAG包括:检索(用查询嵌入获取相关文档)、排序(按相关性排序)、生成(用检索上下文生成准确响应)。提升如问答的任务事实准确性。

37. 专家混合(MoE)如何提升LLM可扩展性?

MoE用门控函数激活特定专家子网络,减少计算负载。例如,每查询仅用10%参数,让亿级参数模型高效运行,同时保持高性能。

38. 思维链(Chain-of-Thought)提示是什么,它如何辅助推理?

CoT提示引导LLM逐步解决问题,模仿人类推理。例如,在数学问题中分解计算,提升复杂任务如逻辑推理的准确性和可解释性。

39. 判别AI和生成AI的区别是什么?

判别AI(如情感分类器)基于输入特征预测标签,建模条件概率。生成AI(如GPT)创建新数据,建模联合概率,适合文本或图像生成,提供创意灵活性。

40. 知识图谱集成如何改善LLM?

知识图谱提供结构化事实数据,通过减少幻觉(验证事实)、改善推理(利用实体关系)、增强上下文来提升LLM。适用于问答和实体识别。

41. 什么是零样本学习(Zero-Shot Learning),LLM如何实现?

零样本学习让LLM使用预训练通用知识执行未训练任务。例如,提示“将此评论分类为积极或消极”,无需特定数据即可推断情感,展示其多功能性。

42. 自适应Softmax如何优化LLM?

自适应Softmax按频率分组词,减少稀有词计算。降低大词汇表成本,加速训练和推理,同时保持准确性,尤其在资源有限环境中。

Transformer通过自注意力(避免顺序依赖)、残差连接(直接梯度流)、层规范化(稳定更新)来缓解。与RNN不同,确保深度模型有效训练。

44. 什么是少样本学习(Few-Shot Learning),其益处是什么?

少样本学习让LLM用少量示例执行任务,利用预训练知识。益处包括减少数据需求、快速适应、成本效率,适合利基任务如特定文本分类。

45. 如何修复LLM生成偏见或错误输出?

解决方法:1. 分析模式(识别偏见来源);2. 增强数据(用平衡数据集和去偏技术);3. 微调(用精选数据或对抗方法重训)。改善公平性和准确性。

编码器将输入序列处理成抽象表示,捕捉上下文。解码器生成输出,使用编码器输出和先前token。在翻译中,编码器理解源语言,解码器产生目标语言,实现有效Seq2Seq任务。

47. LLM与传统统计语言模型的区别是什么?

LLM使用Transformer架构、海量数据集和无监督预训练,而统计模型(如N-gram)依赖简单监督方法。LLM处理长距离依赖、上下文嵌入和多样任务,但需大量计算资源。

48. 什么是超参数,为什么重要?

超参数是预设值,如学习率或批次大小,控制模型训练。它们影响收敛和性能;例如,高学习率可能导致不稳定。调优超参数优化LLM效率和准确性。

49. 什么是大型语言模型(LLM)?

LLM是训练于海量文本语料的AI系统,能理解和生成类人语言。拥有亿级参数,在翻译、摘要和问答中卓越,利用上下文学习广泛适用。

50. LLM部署面临哪些挑战?

挑战包括:资源密集(高计算需求)、偏见(延续训练数据偏见)、可解释性(复杂模型难解释)、隐私(数据安全担忧)。解决这些确保LLM的伦理和有效使用。

参考来源

https://transformers.run/c1/transformer/

/3.jpg)

/1.jpg)

/2.webp)