AI模型尝鲜

离职系列

第十二篇

离职系列,想想这几年在公司的成长,在这做个记录。这篇是关于AI功能方案验证。

背景

落地事业部上一年关于AI的创新奖的方案,更合适的叫法应该是交接,之前的团队几乎停留在理论上和一个demo上,因为久久没有效果,可能感受到了上级的压力,需要看到实际效果,最终找到了我们团队,希望能借助我们团队让其产生价值(官方说法),我理解实际就接这个摊子。

方案介绍

因为在这之前就是一个demo,具体前面的团队也说不出来个所以然,所以我们直接说说两边对话后的方案走向,希望做一个功能:容量预测,意思是根据服务器的多个指标历史数据,预估服务器未来的负载情况,从而给予客户参考或预案。

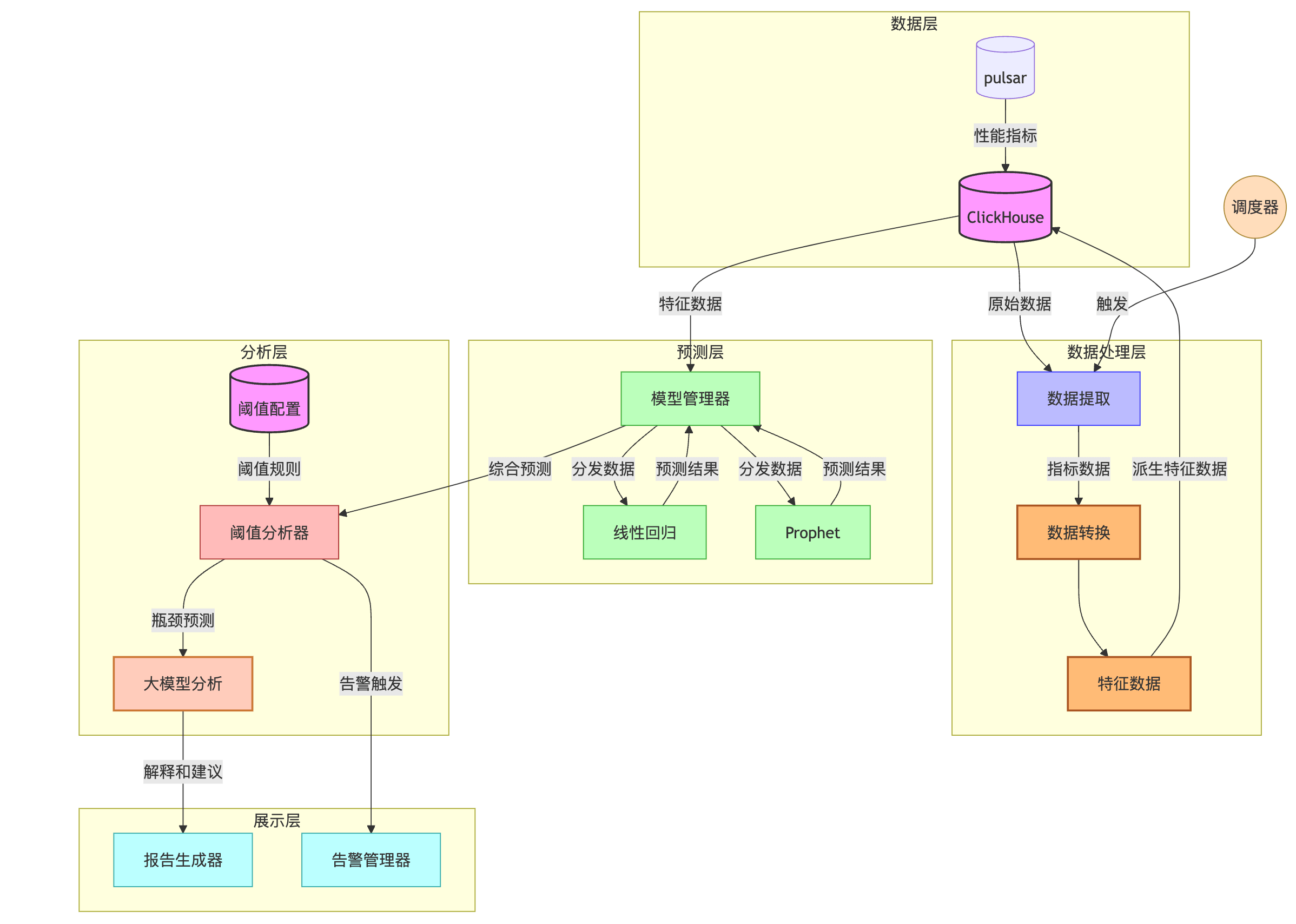

我试着画下大体的方案:

架构图:

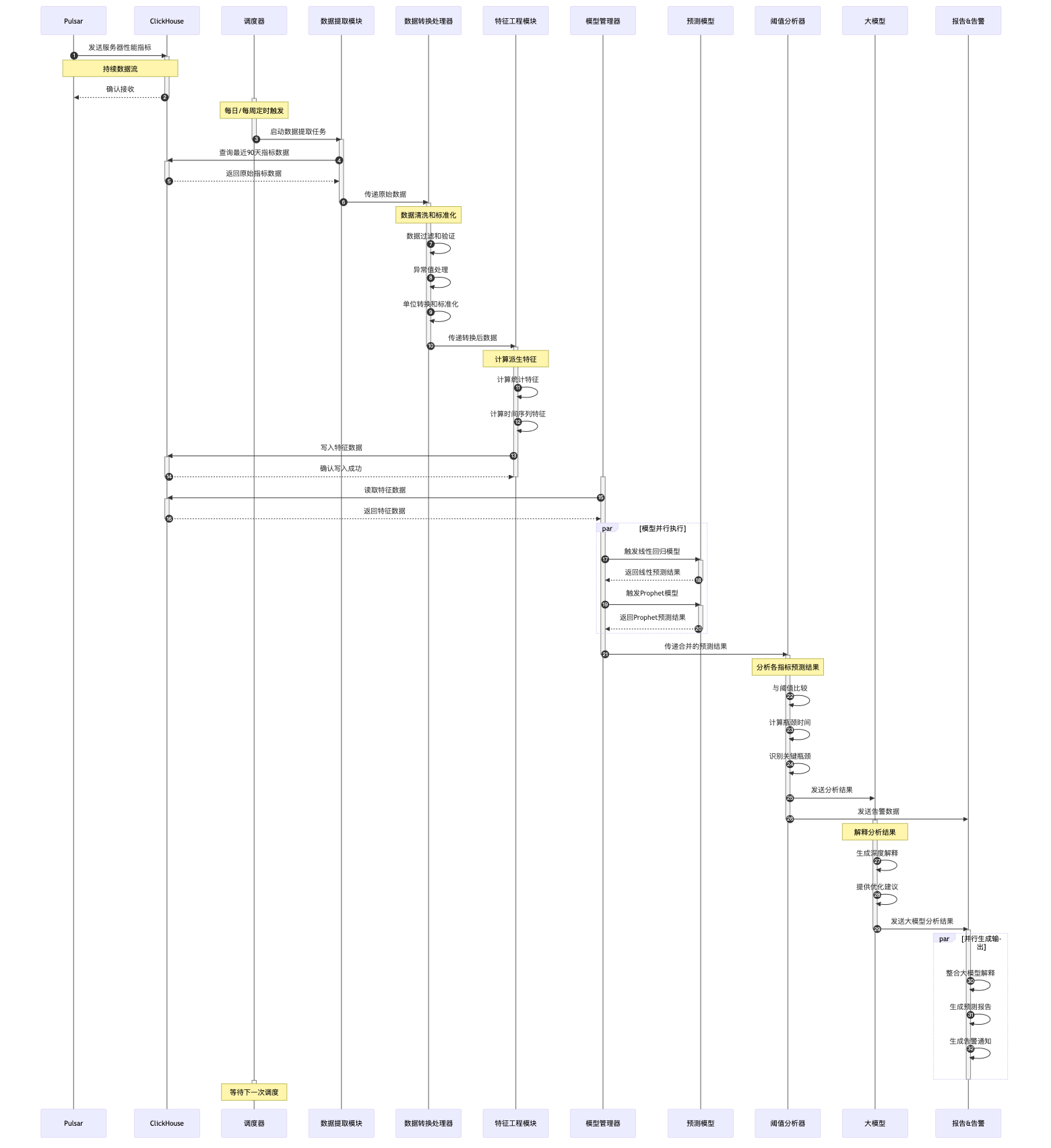

时序图:

大体流程

- 调度器触发flink批任务从ClickHouse获取原始数据

- Flink进行基本的数据清洗和标准化

- 处理后的数据存入CK

- python预测模型从CK获取数据

- 预测模型生成预测结果

- 阈值分析器识别潜在瓶颈

- python大模型提供深度解释和建议

- 生成预测报告和告警

学习链接

ollama

ollama is an open-source tool that simplifies running large language models locally on your personal computer

https://www.youtube.com/watch?v=GWB9ApTPTv4&t=171s